Boston Dynamics는 새로운 전기 Atlas Humanoid가 실험실에서 작업을 수행하는 방법을 강조하는 새로운 비디오를 발표했습니다. 위의 비디오를 볼 수 있습니다.

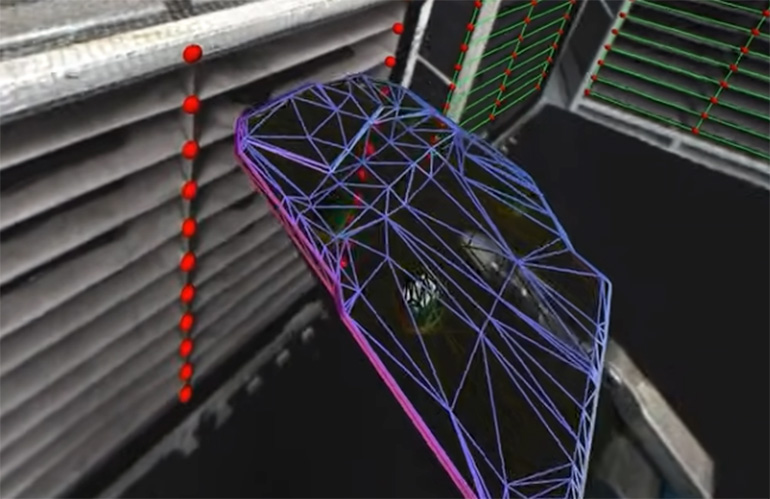

비디오에서 나를 때리는 첫 번째 것은 Atlas가 실시간 인식을 보여주는 방법입니다. 이 비디오는 Atlas가 엔진 커버 및 모든 선택/장소 위치에 대한 참조 프레임을 적극적으로 등록하는 방법을 보여줍니다. 로봇은 세상에 대한 이해를 지속적으로 업데이트하여 부품을 효과적으로 처리합니다. 무언가를 선택하면 부품의 토폴로지, 즉 처리 방법 및 배치 위치를 평가합니다.

아틀라스는 선반에서 부분을 얻을 때 손에 든 부품의 토폴로지를 인식합니다. | 크레딧 : 보스턴 역학

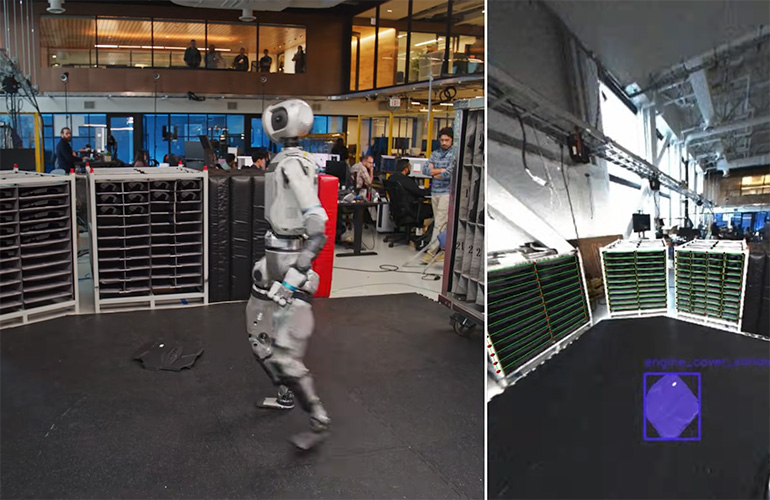

그런 다음 1시 14 분에 데모에는 엔지니어가 엔진 덮개를 바닥에 떨어 뜨린 순간이 있습니다. 아틀라스는 마치 부품이 바닥에 닿는 소리를 듣는 것처럼 반응합니다. 그런 다음 휴머노이드는 주위를 둘러보고 부품을 찾아서 그것을 집어 올리는 방법을 알아 내고 (양식을 평가하고) 엔진 덮개 영역에 필요한 정밀도로 배치합니다.

Boston Dynamics의 Robotics Research의 수석 이사 인 Scott Kuindersma는“이 특정 클립에서 검색 동작이 수동으로 트리거됩니다. 로봇 보고서. “로봇은 오디오 신호를 사용하여지면에 닿는 엔진 덮개를 감지하지 못합니다. 로봇은 자율적으로 바닥에서 물체를 ‘찾는’것이므로 실제로는 동일한 비전 모델을 수동적으로 실행하고 엔진 커버 (또는 우리가 작업하는 부품)가 정상 작동 중에 고정물에서 감지 될 수 있습니다.”

이 비디오는 Atlas의 환경을 적응하고 인식하고 세계에 대한 개념을 조정하는 능력을 강조하며 여전히 할당 된 작업을 고수합니다. 아틀라스가 혼란스러운 환경을 처리하고 작업 목표를 유지하며 즉시 임무를 변경할 수있는 방법을 보여줍니다.

아틀라스는 바닥을 스캔하고 그곳에 속하지 않은 바닥의 부품을 식별 할 수 있습니다. | 크레딧 : 보스턴 역학

Boston Dynamics는“객체가 카메라를 고려할 때 렌더링 포즈 추정 모델을 사용하여 단안 이미지에서 포즈를 추정하기 위해 렌더링 및 컴포지어 접근법을 사용하는 객체 포즈 추정 모델을 사용합니다. “이 모델은 대규모 합성 데이터로 훈련을 받고 CAD 모델이 주어진 새로운 객체에 대한 제로 샷을 일반화합니다. 3D 포즈 이전으로 초기화 할 때 모델은 반복적으로 렌더링 된 CAD 모델과 캡처 된 카메라 이미지 사이의 불일치를 최소화하기 위해이를 개선합니다. 대안 적으로, 포즈 추정기는 2D 영역에서 초기화 될 수 있습니다. 스코어링 모델에 공급되는 가설과 가장 잘 맞는 가설은 이후에 우리가 사내에서 모델링하고 질감 한 수백 개의 공장 자산에 대해 안정적으로 작동합니다.”

그러므로 나는 본다

로봇 비전 지침은 1990 년대부터 실행 가능했습니다. 그 당시 로봇은 이동 컨베이어의 품목을 추적하고 계시를 기반으로 회로 보드 어셈블리의 로컬 참조 프레임을 조정할 수 있습니다. 로봇 비전 지침을위한이 최첨단에 대해서는 놀라운 것은 없습니다.

이제 휴머노이드에게 독특한 것은 로봇의 이동성입니다. 모든 모바일 조작기는 월드 맵을 지속적으로 업데이트해야합니다. Modern Robot Vision Guidance는 VLM (Vision Language Model)을 사용하여 카메라의 눈을 통해 세계를 이해합니다.

이 오래된 산업 로봇은 지상에 고정되어 있으며 2D 비전 및 복잡한 교정 루틴을 사용하여 카메라의 시야를 매핑했습니다. 우리가 Atlas로 보여주는 것은 모바일, 휴머노이드 로봇으로 주변 환경을 이해하고 환경이 로봇 주위의 환경이 바뀌더라도 작업을 계속합니다. 현대 로봇은 주변 세계에 대한 3D 이해를 가지고 있습니다.

Boston Dynamics는이 데모가 AI 기반 기능 (인식과 같은)과 미션 관리를위한 절차 적 프로그래밍의 혼합임을 인정합니다. 이 비디오는 소프트웨어 진화 기능의 진행을 잘 보여줍니다. 이러한 시스템이 실제 세계에서 작동하려면 미묘한 변화와 운영 환경에 대한 거시적 변경을 처리해야합니다.

세상을 가로 지르는 길

아틀라스의 움직임을 보는 것은 흥미 롭습니다. 운동은 때때로 조금 이상해 보이지만 AI가 세상을 어떻게 인식하는지와 그것이 세상을 가로 지르는 선택에 대한 훌륭한 예입니다. 우리는 비디오 에서이 의사 결정의 작은 조각을 목격합니다.

보스턴 역학 이전에 MOCAP (Motion Capture) 기반 동작을 보여주는 비디오를 발표했습니다. MOCAP 비디오는 시스템의 민첩성과 부드러운 입력으로 수행 할 수있는 작업을 보여줍니다. AI 의사 결정 및 통제 하에이 최신 비디오의 멍청함은 Uncanny Valley Involving MoCap 시연에서 먼 길입니다. 우리는 또한 등장했습니다 Boston Dynamics CTO Aaron Saunders는 기조 연설자입니다 에서 2025 로봇 서밋 및 엑스포 보스턴에서.

Atlas가 세계를 이해하기위한 실시간 처리가 많이 남아 있습니다. 비디오에서 우리는 로봇이 결정을 내리고 계속하기 전에 환경을 처리하기 위해 멈추는 것을 봅니다. 나는 코드가 발전하고 AI 모델이 이해력과 적응성에서 더 나아질 때 시간이 지남에 따라 더 빨라질 것이라고 확신합니다. 이 로봇이 적응하고 환경을 이해하며 다양한 다중 모달 데이터에서 지속적으로 학습 할 수있는 AI 기반 소프트웨어 개발.

편집자 주 : 이 기사는 Boston Dynamics의 Robotics Research 수석 책임자 인 Scott Kuindersma의 인용문으로 동부 오후 1시 46 분에 업데이트되었습니다.

게시물 Boston Dynamics의 Atlas Humanoid가 변화하는 환경에 적응하는 방법 먼저 나타났습니다 로봇 보고서.