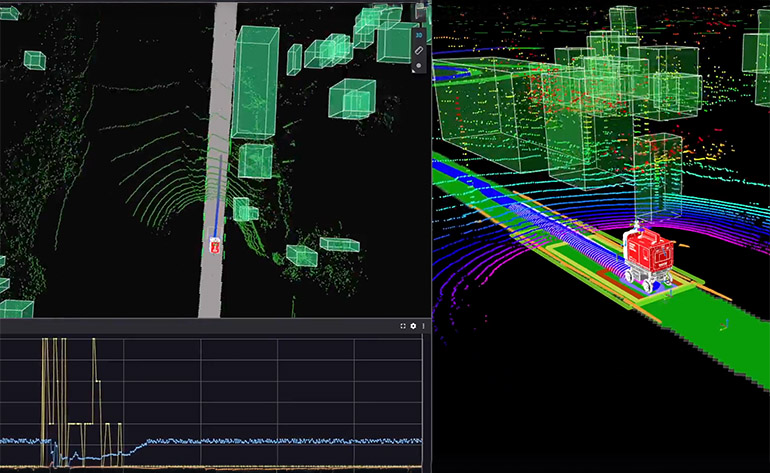

Ottobots는 엣지 로봇에 VLM이 구현된 Contextual AI 2.0을 사용합니다. 출처: 오토노미

자율 배송 로봇 공급업체인 Ottonomy Inc.는 오늘 Ambarella Inc.의 N1 에지 컴퓨팅 하드웨어에서 비전 언어 모델(VLM)을 사용하는 Contextual AI 2.0을 발표했습니다. 회사는 CES에서 자사의 Ottobots가 이제 보다 상황에 맞는 결정을 내리고 지능적인 행동을 보여 일반화된 로봇 지능을 향한 중요한 진전을 이룰 수 있다고 밝혔습니다.

“Ottonomy의 Contextual AI 2.0과 Ambarella의 고급 N1 SoC 제품군의 통합[[칩 위의 시스템]는 자율 로봇 공학의 진화에 있어 중추적인 순간입니다.”라고 Ambarella의 생성 AI 및 로봇 공학 이사인 Amit Badlani는 말했습니다. “결합해서 가장자리 VLM의 혁신적인 잠재력을 갖춘 AI 성능을 통해 로봇이 복잡한 실제 데이터를 실시간으로 처리하고 이에 따라 작업할 수 있도록 지원하고 있습니다.”

Ambarella의 단일 SoC는 낮은 전력 소비로 최대 34개의 B-매개변수 다중 모드 LLM(대형 언어 모델)을 지원합니다. 새로운 N1-655 edge GenAI SoC는 12x 동시 1080p30 비디오 스트림의 온칩 디코드를 제공하는 동시에 해당 비디오를 처리하고 여러 다중 모드 VLM 및 기존 CNN(컨볼루션 신경망)을 실행합니다.

스탠포드 대학교 학생들은 Solo Server를 사용하여 빠르고 안정적이며 미세 조정된 인공 지능을 엣지에 직접 제공했습니다. 이는 환경 처리를 위한 VLM 및 깊이 모델을 배포하는 데 도움이 되었다고 Ottonomy는 설명했습니다.

상황별 AI 2.0은 로봇이 환경을 이해하도록 돕습니다.

Ottonomy는 상황별 AI 2.0이 로봇 인식, 의사 결정 및 행동에 혁명을 가져올 것이라고 주장했습니다. 그만큼 회사 이 기술을 통해 배달 로봇 객체를 감지할 뿐만 아니라 추가 상황에 대한 실제 복잡성을 이해합니다.

Ottonomy는 상황 인식을 통해 Ottobots가 환경, 운영 영역, 심지어 날씨 및 조명 조건에도 더 잘 적응할 수 있다고 설명했습니다.

미리 지정된 행동에 의존하지 않고 상황을 인식하는 로봇의 능력은 “로봇 공학의 일반 지능을 향한 큰 도약”이라고 덧붙였습니다.

“에지 하드웨어의 LLM은 일반 지능에 더 가까이 다가갈 수 있는 게임 체인저입니다. 여기서 우리는 행동 모듈을 연결하여 심층 컨텍스트를 사용하고 상황별 AI 엔진에 추가합니다.”라고 말했습니다. 리투카르 비자이오토노미 CEO. 그는 오늘 오후 2시(태평양 표준시) 라스베거스의 만달레이 베이에서 연설할 예정입니다.

Ottonomy는 VLM에 대한 다양한 애플리케이션을 확인합니다.

Ottonomy는 상황별 AI와 모듈성이 Ottonomy의 “핵심 패브릭”이라고 주장했습니다. SAE 레벨 4 자율 지상 로봇은 실내외 환경 모두에서 백신, 테스트 키트, 전자상거래 패키지는 물론 예비 부품까지 대규모 제조 캠퍼스에 전달합니다.

회사는 의료, 내부물류, 라스트 마일 배송 분야의 고객을 보유하고 있다고 밝혔습니다.

캘리포니아 주 산타모니카에 본사를 둔 Ottonomy는 상품 배송을 위한 혁신적이고 지속 가능한 기술을 개발하는 데 전념하고 있다고 말했습니다. 그만큼 회사 전 세계적으로 규모를 확장하고 있다고 밝혔습니다.

지금 등록하시면 컨퍼런스 패스 40% 할인을 받으실 수 있습니다!

지금 등록하시면 컨퍼런스 패스 40% 할인을 받으실 수 있습니다!

게시물 Ottonomy는 상황별 AI 2.0을 제공하여 VLM을 로봇의 우위에 두었습니다. 처음 등장한 로봇 보고서.