2018년부터 컨소시엄 MLCommons AI 훈련을 위한 일종의 올림픽을 개최해왔습니다. 대회라고 불리는 MLPerf은 사전 정의된 데이터세트를 사용하여 특정 AI 모델을 특정 정확도로 훈련하기 위한 일련의 작업으로 구성됩니다. 기본적으로 벤치마크라고 하는 이러한 작업은 특정 AI 모델을 교육하기 위해 하드웨어 및 하위 수준 소프트웨어 구성이 얼마나 잘 설정되어 있는지 테스트합니다.

1년에 두 번, 기업은 제출물(일반적으로 CPU 및 GPU 클러스터와 이에 최적화된 소프트웨어)을 모아서 누가 제출하면 모델을 가장 빨리 훈련시킬 수 있는지 경쟁합니다.

MLPerf가 시작된 이래로 AI 훈련을 위한 최첨단 하드웨어가 극적으로 향상되었다는 것은 의심의 여지가 없습니다. 수년에 걸쳐, 엔비디아 가지다 출시된 네 새로운 세대 이후 업계 표준이 된 GPU의 비율(최신 Nvidia의 Blackwell GPU는 아직 표준은 아니지만 인기가 높아지고 있음) MLPerf에서 경쟁하는 회사들도 훈련 작업을 처리하기 위해 더 큰 GPU 클러스터를 사용해 왔습니다.

그러나 MLPerf 벤치마크도 더욱 어려워졌습니다. 그리고 이러한 엄격함의 증가는 의도적으로 설계된 것입니다. 벤치마크는 업계와 보조를 맞추려고 노력하고 있다고 말합니다. 데이비드 캔터MLPerf 책임자. “벤치마크는 대표성을 갖기 위한 것입니다.”라고 그는 말합니다.

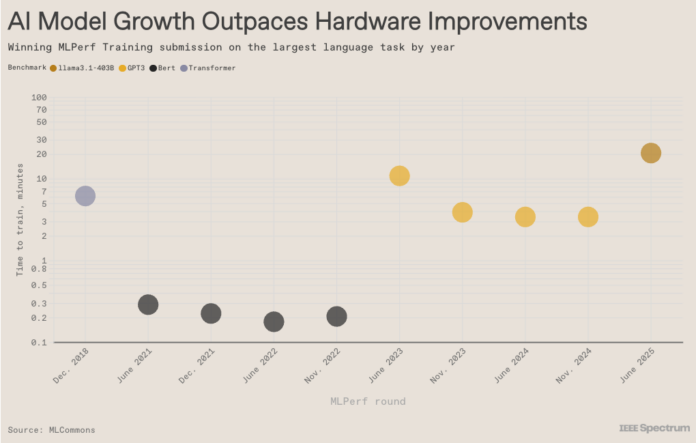

흥미롭게도 데이터는 대규모 언어 모델과 그 이전 모델의 크기가 하드웨어가 유지하는 것보다 더 빠르게 증가하고 있음을 보여줍니다. 따라서 새로운 벤치마크가 도입될 때마다 가장 빠른 훈련 시간이 길어집니다. 그런 다음 하드웨어 개선으로 인해 실행 시간이 점차 줄어들다가 다음 벤치마크에서 다시 좌절됩니다. 그런 다음주기가 반복됩니다.

이 기사는 2025년 11월 인쇄본에 게재됩니다.