세레브라스 시스템고성능 AI 컴퓨팅의 선구자인 Cerebras Inference는 AI 추론을 혁신할 획기적인 솔루션을 출시했습니다. 2024년 8월 27일, 이 회사는 세계에서 가장 빠른 AI 추론 서비스인 Cerebras Inference를 출시한다고 발표했습니다. 기존 GPU 기반 시스템의 성능 지표를 압도하는 Cerebras Inference는 비용의 일부로 20배 빠른 속도를 제공하여 AI 컴퓨팅의 새로운 벤치마크를 설정했습니다.

전례 없는 속도와 비용 효율성

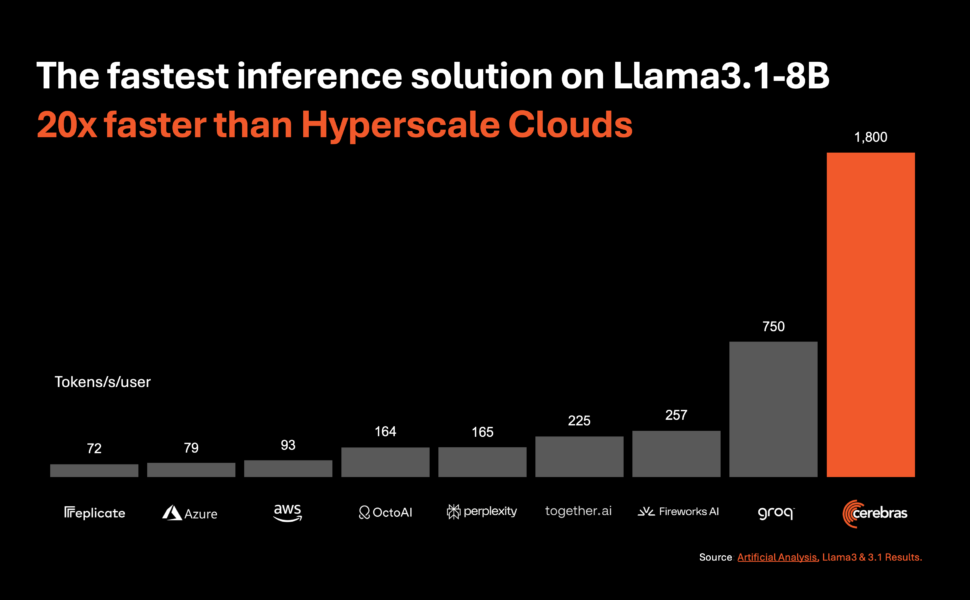

Cerebras Inference는 특히 빠르게 진화하는 부문에서 다양한 AI 모델에서 뛰어난 성능을 제공하도록 설계되었습니다. 대규모 언어 모델 (LLM). 예를 들어, Llama 3.1 8B 모델의 경우 초당 1,800개의 토큰을 처리하고 Llama 3.1 70B 모델의 경우 초당 450개의 토큰을 처리합니다. 이 성능은 NVIDIA GPU 기반 솔루션보다 20배 빠를 뿐만 아니라 비용도 상당히 낮습니다. Cerebras는 Llama 3.1 8B 모델의 경우 백만 토큰당 10센트, Llama 3.1 70B 모델의 경우 백만 토큰당 60센트부터 이 서비스를 제공하며, 기존 GPU 기반 제품에 비해 가격 대비 성능이 100배 향상되었습니다.

속도의 경계를 넓히면서 정확성 유지

Cerebras Inference의 가장 인상적인 측면 중 하나는 타의 추종을 불허하는 속도를 제공하면서도 최첨단 정확도를 유지할 수 있는 능력입니다. 속도를 위해 정밀도를 희생하는 다른 접근 방식과 달리 Cerebras의 솔루션은 추론 실행 전체에 걸쳐 16비트 도메인 내에 머물러 있습니다. 이를 통해 성능 향상이 AI 모델 출력의 품질을 희생하지 않도록 보장하며, 이는 정밀도에 집중하는 개발자에게 중요한 요소입니다.

Artificial Analysis의 공동 창립자이자 CEO인 Micah Hill-Smith는 이 성과의 중요성을 다음과 같이 강조했습니다.Cerebras는 Meta의 Llama 3.1 8B 및 70B AI 모델에 대해 GPU 기반 솔루션보다 훨씬 빠른 속도를 제공합니다. Llama 3.1 8B에서 초당 1,800개 출력 토큰 이상, Llama 3.1 70B에서 초당 446개 출력 토큰 이상의 속도를 측정하고 있습니다. 이는 이러한 벤치마크에서 새로운 기록입니다.”

AI 추론의 중요성이 커짐

AI 추론 AI 컴퓨팅에서 가장 빠르게 성장하는 부문으로, 전체 AI 하드웨어 시장의 약 40%를 차지합니다. Cerebras가 제공하는 것과 같은 고속 AI 추론의 출현은 광대역 인터넷의 도입과 유사하여 새로운 기회를 열고 AI 애플리케이션의 새로운 시대를 예고합니다. Cerebras Inference를 통해 개발자는 이제 AI 에이전트 및 지능형 시스템과 같이 복잡하고 실시간 성능이 필요한 차세대 AI 애플리케이션을 구축할 수 있습니다.

DeepLearning.AI의 설립자인 Andrew Ng는 AI 개발에서 속도의 중요성을 강조했습니다.DeepLearning.AI에는 결과를 얻기 위해 LLM을 반복적으로 촉구해야 하는 여러 에이전트 워크플로가 있습니다. Cerebras는 이러한 워크로드에 매우 도움이 될 놀라울 정도로 빠른 추론 기능을 구축했습니다.”

광범위한 산업 지원 및 전략적 파트너십

Cerebras는 업계 리더로부터 강력한 지원을 얻었으며 AI 애플리케이션 개발을 가속화하기 위한 전략적 파트너십을 형성했습니다. Cerebras의 초기 고객인 GlaxoSmithKline의 AI/ML 담당 수석 부사장인 킴 브랜슨은 이 기술의 혁신적 잠재력을 강조했습니다. “속도와 규모가 모든 것을 바꾼다.”

LiveKit과 같은 다른 회사 당황Meter도 Cerebras Inference가 자사 운영에 미칠 영향에 대한 열정을 표명했습니다. 이 회사들은 Cerebras의 컴퓨팅 역량을 활용하여 더욱 반응성이 뛰어나고 인간과 유사한 AI 경험을 만들고, 검색 엔진에서 사용자 상호 작용을 개선하고, 네트워크 관리 시스템을 강화하고 있습니다.

Cerebras 추론: 계층 및 접근성

Cerebras Inference는 무료, 개발자, 엔터프라이즈의 세 가지 경쟁력 있는 가격 계층에서 제공됩니다. 무료 계층은 관대한 사용 한도로 무료 API 액세스를 제공하여 광범위한 사용자가 액세스할 수 있습니다. 개발자 계층은 유연한 서버리스 배포 옵션을 제공하며, Llama 3.1 모델은 백만 토큰당 10센트와 60센트로 가격이 책정됩니다. 엔터프라이즈 계층은 지속적인 작업 부하가 있는 조직을 대상으로 미세 조정된 모델, 맞춤형 서비스 수준 계약 및 전담 지원을 제공하며, 요청 시 가격을 제공합니다.

Cerebras Inference에 동력을 공급: Wafer Scale Engine 3(WSE-3)

Cerebras Inference의 핵심은 업계를 선도하는 Wafer Scale Engine 3(WSE-3)으로 구동되는 Cerebras CS-3 시스템입니다. 이 AI 프로세서는 크기와 속도 면에서 타의 추종을 불허하며 NVIDIA의 H100보다 7,000배 더 많은 메모리 대역폭을 제공합니다. WSE-3의 방대한 규모 덕분에 많은 동시 사용자를 처리할 수 있어 성능 저하 없이 엄청난 속도를 보장합니다. 이 아키텍처를 통해 Cerebras는 일반적으로 GPU 기반 시스템을 괴롭히는 트레이드오프를 피하고 AI 워크로드에 동급 최고의 성능을 제공할 수 있습니다.

원활한 통합 및 개발자 친화적 API

Cerebras Inference는 개발자를 염두에 두고 설계되었습니다. OpenAI Chat Completions API와 완벽하게 호환되는 API를 제공하여 최소한의 코드 변경으로 쉽게 마이그레이션할 수 있습니다. 이 개발자 친화적인 접근 방식은 Cerebras Inference를 기존 워크플로에 통합하는 것이 가능한 한 원활하게 이루어지도록 보장하여 고성능 AI 애플리케이션을 빠르게 배포할 수 있습니다.

Cerebras Systems: 산업 전반에 걸쳐 혁신을 추진하다

Cerebras Systems는 AI 컴퓨팅의 선두주자일 뿐만 아니라 의료, 에너지, 정부, 과학 컴퓨팅, 금융 서비스를 포함한 다양한 산업에서 핵심적인 역할을 합니다. 이 회사의 솔루션은 National Laboratories, Aleph Alpha, The Mayo Clinic, GlaxoSmithKline과 같은 기관에서 획기적인 발전을 이루는 데 중요한 역할을 했습니다.

Cerebras는 타의 추종을 불허하는 속도, 확장성, 정확성을 제공함으로써 이러한 부문 전반의 조직이 AI 및 그 너머에서 가장 어려운 문제 중 일부를 해결할 수 있도록 지원합니다. 의료 분야에서 약물 발견을 가속화하든 과학 연구에서 계산 능력을 향상하든 Cerebras는 혁신을 주도하는 최전선에 있습니다.

결론: AI 추론의 새로운 시대

Cerebras Systems는 Cerebras Inference를 출시하면서 AI 추론의 새로운 표준을 정립하고 있습니다. 기존 GPU 기반 시스템보다 20배 빠른 속도를 훨씬 낮은 비용으로 제공함으로써 Cerebras는 AI를 더 쉽게 이용할 수 있게 할 뿐만 아니라 차세대 AI 애플리케이션을 위한 길을 닦고 있습니다. 최첨단 기술, 전략적 파트너십, 혁신에 대한 헌신을 바탕으로 Cerebras는 AI 산업을 전례 없는 성능과 확장성의 새로운 시대로 이끌 준비가 되어 있습니다.

Cerebras Systems에 대한 자세한 정보를 알아보거나 Cerebras Inference를 시도하려면 다음을 방문하세요. www.세레브라스.ai.

게시물 Cerebras, 세계에서 가장 빠른 AI 추론 솔루션 출시: 비용은 훨씬 저렴하면서 속도는 20배 빨라 처음 등장 유나이트.AI.