AI의 새로운 시대

1 년 전, Microsoft는 소개했습니다 작은 언어 모델 (SLMS) 릴리스가있는 고객에게 PHI-3 ~에 Azure AI FoundrySLM에 대한 연구를 활용하여 고객이 사용할 수있는 효율적인 AI 모델 및 도구 범위를 확장합니다.

오늘, 우리는 소개하게되어 기쁩니다 Phi-4-reasoning, Phi-4-reasoning-plus 및 Phi-4-Mini-reasoning– 작은 언어 모델에 대한 새로운 시대를 마킹하고 작고 효율적인 AI로 가능한 것을 다시 한 번 재정의합니다.

추론 모델, 다음 단계

추론 모델 다단계 분해 및 내부 반사를 요구하는 복잡한 작업을 수행하기 위해 추론 시간 스케일링을 활용하도록 교육을받습니다. 그것들은 수학적 추론에 탁월하며 복잡하고다면적인 작업을 가진 에이전트 응용 프로그램의 중추로 떠오르고 있습니다. 이러한 기능은 일반적으로 대형 프론티어 모델에서만 발견됩니다. Phi-reasoning 모델은 새로운 범주의 작은 언어 모델을 소개합니다. 증류, 강화 학습 및 고품질 데이터를 사용 하여이 모델은 균형 크기 및 성능을 제공합니다. 이들은 대기 시간이 낮지 만 훨씬 더 큰 모델과 경쟁하는 강력한 추론 능력을 유지합니다. 이 블렌드를 사용하면 리소스 제한 장치조차도 복잡한 추론 작업을 효율적으로 수행 할 수 있습니다.

Phi-4-reasoning 및 Phi-4-reasoning-plus

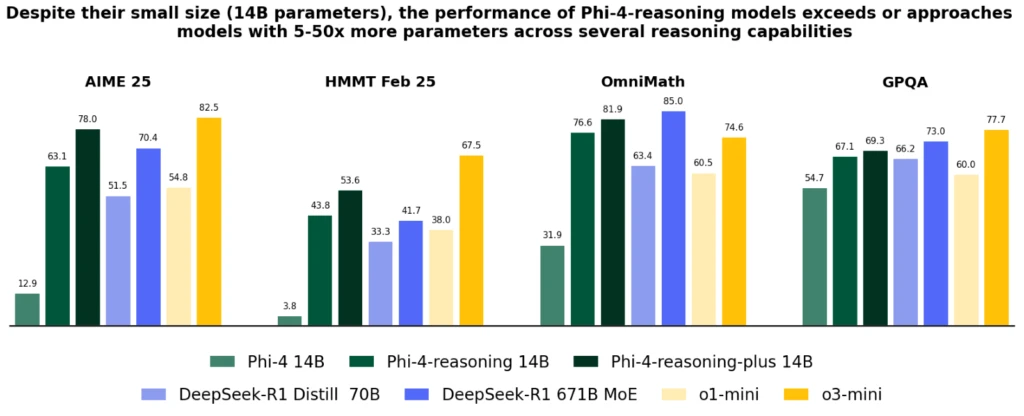

Phi-4-reasoning 복잡한 추론 작업에서 훨씬 더 큰 모델을 경쟁하는 14 억 개의 매개 변수 오픈-가이트 추론 모델입니다. OpenAI O3-Mini의 신중하게 선별 된 추론 시연에 대한 PHI-4의 감독 된 미세 조정을 통해 교육을받은 PHI-4-Reasoning은 추가 추론 시간 컴퓨팅을 효과적으로 활용하는 상세한 추론 체인을 생성합니다. 이 모델은 세심한 데이터 큐 레이션 및 고품질 합성 데이터 세트가 소규모 모델이 더 큰 대응 물과 경쟁 할 수 있음을 보여줍니다.

Phi-4-reasoning-plus PHI-4- 계급 기능을 기반으로, PHI-4- 계급보다 1.5 배 더 많은 토큰을 사용하여 더 높은 정확도를 제공하기 위해 더 많은 추론 시간 컴퓨팅을 활용하기 위해 강화 학습을 위해 더 많은 교육을 받았습니다.

크기가 상당히 작음에도 불구하고 두 모델 모두 수학적 추론 및 Ph.D. 레벨 과학 질문. 그들은 USA Math Olympiad의 2025 예선 인 AIME 2025 테스트에서 전체 DeepSeek-R1 모델 (671 억 파라미터)보다 성능을 향상시킵니다. 두 모델 모두에서 사용할 수 있습니다 Azure AI Foundry 그리고 포옹, 여기 그리고 여기.

PHI-4- 계급 모델은 PHI-4에 비해 크게 개선되었으며 DeepSeek-R1-Distill-70B와 같은 대규모 모델을 능가하고 수학, 코딩, 알고리즘 문제 해결 및 계획을 포함한 다양한 추론 및 일반적인 기능에 걸쳐 Deep-Seek-R1에 접근합니다. 그만큼 기술 보고서 다양한 추론 작업을 통해 이러한 개선에 대한 광범위한 정량적 증거를 제공합니다.

Phi-4-Mini-reasoning

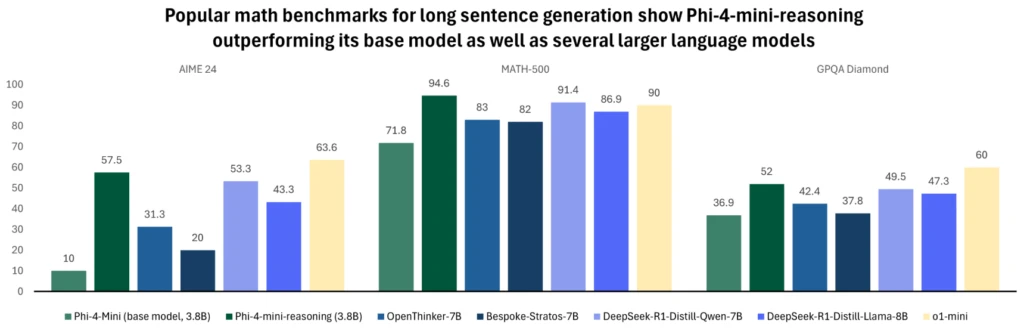

Phi-4-Mini-reasoning 컴팩트 한 추론 모델에 대한 수요를 충족 시키도록 설계되었습니다. 이 변압기 기반 언어 모델은 수학적 추론에 최적화되어 컴퓨팅 또는 대기 시간이 제한된 환경에서 고품질의 단계별 문제 해결을 제공합니다. DeepSeek-R1 모델에 의해 생성 된 합성 데이터로 미세 조정 된 PHI-4-MINI- 계급은 고급 추론 능력과 효율성을 균형을 유지합니다. Edge 또는 Mobile Systems의 교육 응용 프로그램, 임베드 된 과외 및 가벼운 배치에 이상적이며 중학교에서 박사 학위에 이르기까지 여러 수준의 난이도에 걸친 백만 개 이상의 다양한 수학 문제에 대해 교육을받습니다. 수준. 모델을 사용해보십시오 Azure AI Foundry 또는 포옹 페이스 오늘.

모델에 대한 자세한 내용은 다음을 참조하십시오기술 보고서 추가적인 정량적 통찰력을 제공합니다.

PHI 추론 모델이 작동합니다

작년에 Phi의 진화는이 품질과 크기의 외피를 지속적으로 밀어내어 다양한 요구를 해결하기 위해 새로운 기능으로 가족을 확장했습니다. Windows 11 장치의 규모에 따라 이러한 모델은 CPU 및 GPU에서 로컬로 실행할 수 있습니다.

Windows가 새로운 유형의 PC를 만들기 위해 작동함에 따라 PHI 모델은 NPU에서 최적화 된 Copilot+ PC의 필수 부분이되었습니다. Phi 실리카 변형. 이 고도로 효율적이고 OS 관리 버전의 PHI는 메모리에 사전로드되도록 설계되었으며 첫 번째 토큰 응답에 빠른 시간과 전력 효율적인 토큰 처리량으로 파워를 사용하여 PC에서 실행되는 다른 응용 프로그램과 동시에 호출 할 수 있습니다.

그것은 핵심 경험과 같은 핵심 경험에 사용됩니다 클릭하십시오화면의 모든 컨텐츠에 유용한 텍스트 인텔리전스 도구를 제공하며 개발자 API Outlook과 같은 여러 생산성 응용 프로그램에서 사용되는 준비가되어 있으며 Copillot 요약 기능을 오프라인으로 제공합니다. 이 작지만 강력한 모델은 이미 PC 생태계의 폭에 걸쳐 여러 응용 분야에서 사용되도록 이미 최적화되어 통합되었습니다. Phi-4-reasoning 및 Phi-4-Mini-reasoning 모델은 PHI 실리카의 저용량 최적화를 활용하며 곧 Copilot+ PC NPU에서 실행할 수 있습니다.

책임있는 AI에 대한 안전 및 Microsoft의 접근

Microsoft에서 책임있는 AI PHI 모델을 포함하여 AI 시스템의 개발 및 배포를 안내하는 기본 원칙입니다. PHI 모델은 책임, 투명성, 공정성, 신뢰성 및 안전, 개인 정보 보호 및 보안 및 포용성과 같은 Microsoft AI 원칙에 따라 개발됩니다.

PHI 모델의 모델은 감독 된 미세 조정 (SFT), 직접 선호도 최적화 (DPO) 및 인간 피드백 (RLHF) 기술로부터의 강화 학습의 조합을 활용하여 강력한 안전 후 훈련 접근법을 채택했습니다. 이 방법은 도움과 무해함에 중점을 둔 공개적으로 사용 가능한 데이터 세트와 다양한 안전 관련 질문 및 답변을 포함하여 다양한 데이터 세트를 사용합니다. Phi 모델 패밀리는 광범위한 작업을 효과적으로 수행하도록 설계되었지만 모든 AI 모델이 한계를 나타낼 수 있음을 인정하는 것이 중요합니다. 이러한 제한 사항과이를 해결하기위한 조치를 더 잘 이해하려면 책임있는 AI 관행 및 지침에 대한 자세한 정보를 제공하는 아래 모델 카드를 참조하십시오.

자세히 알아보기 :

- 새로운 모델을 사용해보십시오 Azure AI Foundry.

- 읽으십시오 Phi Cookbook.

- 읽으십시오 에지 장치의 PHI 추론 모델.

- 자세히 알아보십시오 Phi-4-Mini-reasoning.

- 자세히 알아보십시오 Phi-4-reasoning.

- 자세히 알아보십시오 Phi-4-reasoning-plus.

- PHI 추론에 대해 자세히 알아보십시오 교육자 개발자 블로그.

게시물 1 년의 PHI : AI에서 큰 도약을하는 작은 언어 모델 먼저 나타났습니다 Microsoft AI 블로그.