최첨단 아키텍처는 추론 모델을위한 속도를 재정의합니다.

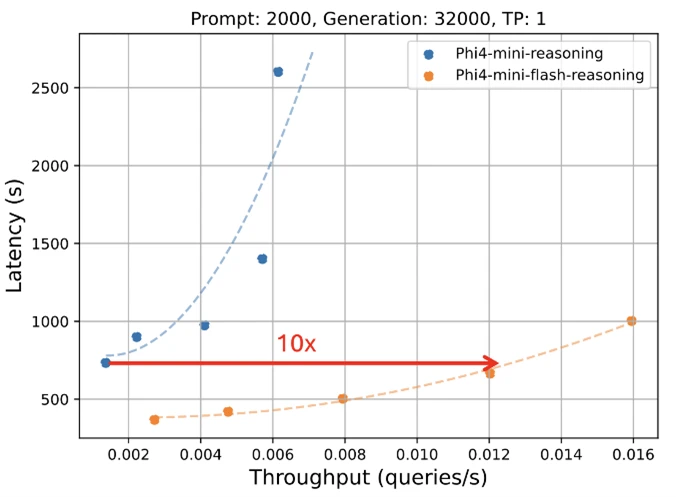

Microsoft는 PHI 모델 제품군에 새 버전을 공개하게되어 기쁩니다. Phi-4-Mini-Flash-reasoning. 컴퓨팅, 메모리 및 대기 시간이 엄격하게 제한되는 시나리오에 대한 목적으로 제작 된이 새로운 모델은 고급기구, 모바일 애플리케이션 및 기타 리소스 제약 환경에 고급 추론 기능을 제공하도록 설계되었습니다. 이 새로운 모델은 PHI-4-MINI를 따르지만 새로운 하이브리드 아키텍처를 기반으로하여 최대 10 배 더 높은 처리량과 대기 시간의 평균 감소를 달성하여 추론 성능을 희생하지 않으면 서 상당히 빠른 추론을 가능하게합니다. 효율성과 유연성을 요구하는 실제 솔루션에 전원을 공급할 준비가되어 있습니다. Azure AI Foundry,,, NVIDIA API 카탈로그그리고 포옹 얼굴 오늘.

타협없이 효율성

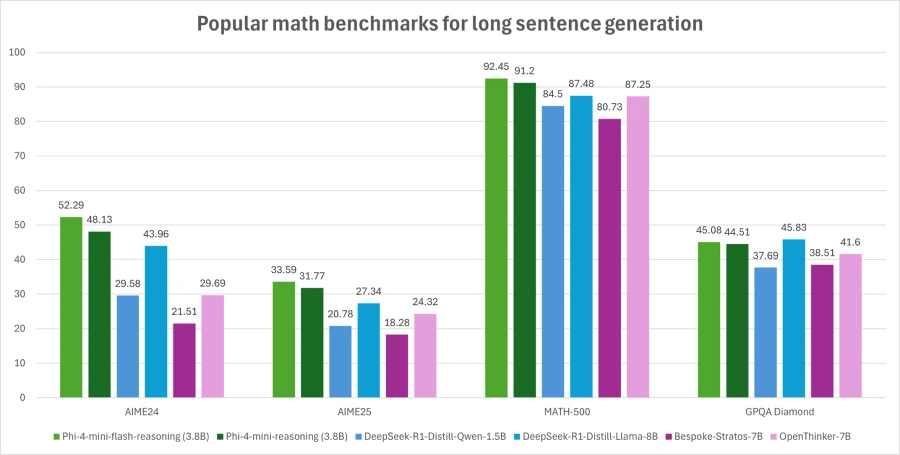

PHI-4-MINI-FLASH-A CENARINGING은 수학 추론 능력의 효율성 균형을 유지하여 교육 응용 프로그램, 실시간 로직 기반 응용 프로그램 등에 잠재적으로 적합합니다.

전임자와 마찬가지로 PHI-4-MINI-FLASH-A CENARYING은 고급 수학 추론에 최적화 된 38 억 파라미터 오픈 모델입니다. 64K 토큰 컨텍스트 길이를 지원하며 신뢰할 수있는 논리 집약적 인 성능 배포를 제공하기 위해 고품질 합성 데이터에 미세 조정됩니다.

새로운 것은 무엇입니까?

PHI-4-MINI-FLASH-A CENARYING의 핵심에는 새로 도입 된 디코더-하이브리드 디코더 아키텍처 인 Sambay가 있습니다. 아키텍처에는 Mamba (상태 공간 모델)와 SWA (Sliding Wind 이 아키텍처에는 새롭고 효율적인 GMU와 비싼 크로스 텐션 레이어를 삽입하는 교차 디코더도 포함됩니다. GMU 모듈이있는이 새로운 아키텍처는 디코딩 효율을 크게 향상시키고, 긴 컨텍스트 검색 성능을 향상시키고, 아키텍처가 광범위한 작업에서 뛰어난 성능을 제공 할 수있게합니다.

Sambay 아키텍처의 주요 이점은 다음과 같습니다.

- 향상된 디코딩 효율.

- 선형 선결 시간 복잡성을 보존합니다.

- 확장 성이 향상되고 긴 컨텍스트 성능이 향상되었습니다.

- 최대 10 배 더 높은 처리량.

PHI-4-MINI-FLASH-A CENARYING 벤치 마크

PHI 패밀리의 모든 모델과 마찬가지로 PHI-4-MINI-FLASH-REASSIONING은 단일 GPU에 배치 할 수 있으므로 광범위한 사용 사례에 액세스 할 수 있습니다. 그러나 그것을 차별화하는 것은 건축 적 이점입니다. 이 새로운 모델은 PHI-4-MINI- 계급, 특히 장기 텍스트 생성 및 대기 시간에 민감한 추론 작업에서 상당히 낮은 대기 시간과 처리량을 달성합니다.

이로 인해 PHI-4-MINI-FLASH REANSEND는 건물이나 기기에 대한 빠르고 확장 가능하며 효율적인 추론이 필요한 지능형 시스템을 배포하려는 개발자와 기업을위한 강력한 옵션이됩니다.

잠재적 인 사용 사례는 무엇입니까?

대기 시간 감소, 처리량 향상 및 수학 추론에 중점을 두어 모델은 다음에 이상적입니다.

- 적응 형 학습 플랫폼실시간 피드백 루프가 필수적인 경우.

- 기기 추론 보조원모바일 연구 보조제 또는 에지 기반 논리 에이전트와 같은.

- 대화식지도 시스템 이는 학습자의 성능에 따라 콘텐츠 난이도를 동적으로 조정합니다.

수학 및 구조적 추론의 강점은 교육 기술, 경량 시뮬레이션 및 빠른 응답 시간에 대한 신뢰할 수있는 논리 추론이 필요한 자동 평가 도구에 특히 가치가 있습니다.

개발자는 Microsoft Developer Discord 커뮤니티 질문을하고, 피드백을 공유하고, 실제 사용 사례를 함께 탐색하십시오.

신뢰할 수있는 AI에 대한 Microsoft의 약속

산업 전반의 조직은 Azure AI를 활용하고 있습니다 Microsoft 365 Copilot 성장을 주도하고 생산성을 높이며 부가가치 경험을 창출하는 기능.

우리는 조직이 사용하고 구축하도록 돕기 위해 노력하고 있습니다 신뢰할 수있는 AI안전하고 개인적이며 안전하다는 것을 의미합니다. 우리는 수십 년간의 AI 제품을 연구하고 구축하여 체계적인 모범 사례와 학습을 가져와 보안, 개인 정보 및 안전의 세 가지 기둥에 걸쳐있는 업계 최고의 약속과 기능을 제공합니다. 신뢰할 수있는 AI는 귀하가 우리의 약속을 결합 할 때만 가능합니다. 미래의 이니셔티브를 확보하십시오 그리고 우리 책임있는 AI 원칙AI 변환을 자신감있게 잠금 해제하는 제품 기능을 갖추고 있습니다.

PHI 모델은 책임, 투명성, 공정성, 신뢰성 및 안전, 개인 정보 보호 및 보안 및 포용성과 같은 Microsoft AI 원칙에 따라 개발됩니다.

PHI-4-MINI-FLASH-A CENARYING을 포함한 PHI 모델 패밀리는 감독 된 미세 조정 (SFT), 직접 환경 설정 최적화 (DPO) 및 인간 피드백 (RLHF)의 강화 학습을 통합하는 강력한 안전 후 훈련 전략을 사용합니다. 이러한 기술은 오픈 소스 및 독점 데이터 세트의 조합을 사용하여 적용되며, 도움을 보장하고, 유해한 출력을 최소화하며, 광범위한 안전 범주를 다루는 데 중점을 둡니다. 개발자는 특정 사용 사례 및 문화적 맥락에 맞는 책임있는 AI 모범 사례를 적용하도록 권장됩니다.

위험 및 완화 전략에 대해 자세히 알아 보려면 모델 카드를 읽으십시오.

새로운 모델에 대해 자세히 알아보십시오

- 새로운 모델을 사용해보십시오Azure AI Foundry.

- 코드 샘플 등을 찾으십시오Phi Cookbook.

- PHI-4-MINI-FLASH-A CENARYING 기술 논문을 읽으십시오 arxiv.

- 궁금한 점이 있으면 가입하십시오 Microsoft 개발자“Ask Me 뭐든지”.

Azure AI Foundry로 만듭니다

- 시작하십시오 Azure AI Foundry그리고 직접 뛰어 들어 비주얼 스튜디오 코드.

- 다운로드 Azure AI Foundry SDK.

- 가져 가라 Azure AI Foundry는 코스를 배웁니다.

- 검토 Azure AI Foundry 문서 .

- 대화를 계속하십시오 기럽그리고 불화 .

게시물 추론 재사용 : Phi-4-Mini-flash-reasoning 소개먼저 나타났습니다 Microsoft AI 블로그.